基辛格访华:这一表态暗藏玄机,此前称各国人工智能的战略转型堪比当年的核武器(8)

第五,世界各国,特别是技术强国,应制定强有力和可接受的方法,在紧张局势加剧和极端情况下尽量延长决策时间。这应该是一个共同的概念性目标,特别是在竞争对手之间,它可以将控制不稳定性和建立共同安全所需的步骤(既有当前的,也有长期的)联系起来。在危机中,人类必须对是否使用先进武器承担最终责任。特别是竞争对手间应该努力就一种机制达成一致,以确保那些可能不可撤销的决定是以有助于人类对其加以思考并有利于人类生存的方式做出的。

第六,主要的人工智能大国应该考虑如何限制军事化人工智能的继续扩散,或者依靠外交手段与武力威胁,开展系统性的防扩散工作。那些野心勃勃地想要将技术用于不可接受的破坏性目的的技术收购者会是谁?有哪些特定的人工智能武器值得我们特别关注?谁来确保这条红线不被逾越?老牌的核大国探索过这种防核扩散概念,结果成败参半。如果一种具有颠覆性和潜在破坏性的新技术被用于武装世界上怀有最强烈敌意或道德上最不受约束的政府的军队,那么战略均势可能难以实现,冲突也可能无法控制。

由于大多数人工智能技术具有军民两用特性,我们有责任在这场技术研发竞赛中保持领先。但这也同样迫使我们去理解它的局限性。等到危机来临才开始讨论这些问题就为时已晚了。一旦在军事冲突中使用,人工智能技术的响应速度之快,几乎注定它将以比外交手段更快的速度产生结果。大国之间必须就网络和人工智能武器展开讨论,哪怕只是为了形成一套共同的战略概念话语,以及感知彼此的红线。

要在最具破坏性的能力上实现相互制约,绝不能等到悲剧发生再去亡羊补牢。当人类开始在创造新的、不断演化的、拥有智能的武器方面展开竞争时,历史不会原谅任何对此设限的失败。在人工智能时代,对国家优势的持久追求,仍须以捍卫人类伦理为前提。”

基辛格的论述有一个一以贯之的思想:自有记载的人类历史起,安全始终是一个有组织的社会追求的最低目标。

“主要大国不应等到危机发生才开始就这些演变的战略、学说和道德影响展开对话。如果它们对此坐视不理,影响将是不可逆的。”(责任编辑:傅鑫)

精选推荐

这件事要黄,特朗普真急了

2025-04-24 09:27:01

一夜之间 印巴局势突然升级,印度针对巴基斯坦出台多项反制举措

2025-04-24 14:22:50特朗普紧急会晤这些巨头 讨论关税影响

2025-04-24 10:42:12曝美对华关税或降至约50%至65% 经济网报道

2025-04-24 08:50:57

在中美之间二选一?韩国表态 避免零和博弈

2025-04-24 14:40:57

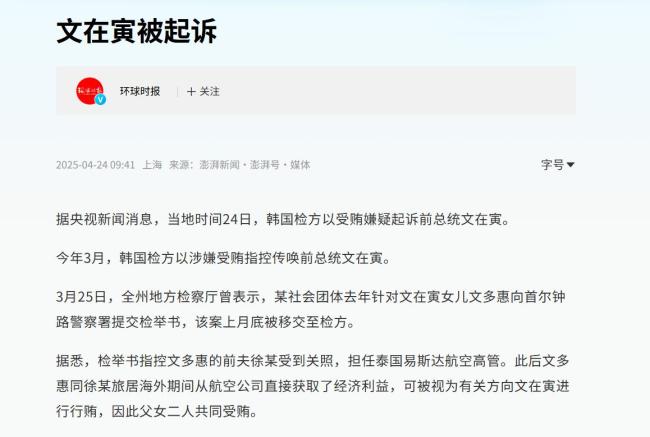

学者:文在寅和李在明“命悬一线” 政坛风波再起

2025-04-24 14:39:57

美航母又炸胡塞武装 昼夜不停空袭 红海激烈交锋升级

2025-04-24 11:31:03

洛马:F35升级后 能以一半价格实现F47八成战力

2025-04-24 09:31:48

英国航母为何敢碰瓷辽宁舰和山东舰 英媒炒作背后的真实意图

2025-04-24 08:58:40

台湾自制潜艇“跳票”后又传性能大打折扣,“最强水面战舰”也起火了……

2025-04-24 09:29:15